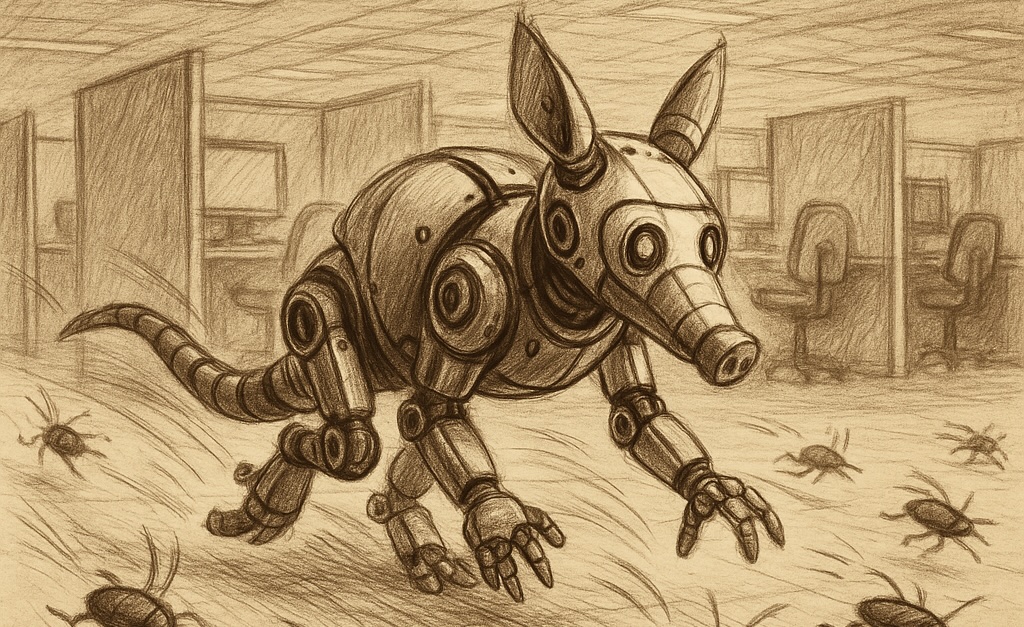

Ett AI-baserat utvecklingsverktyg som gräver fram buggar i programvara – det släpps nu av Open AI i en betaversion. Området är hett och myllrar av aktivitet. Nu träder ett av världens rikaste AI-företag in på arenan.

Ett AI-baserat utvecklingsverktyg som gräver fram buggar i programvara – det släpps nu av Open AI i en betaversion. Området är hett och myllrar av aktivitet. Nu träder ett av världens rikaste AI-företag in på arenan.

Open AI:s buggverktyg heter Aardvark.

Exakt hur mycket nytta Aardvark och andra LLM-baserade buggverktyg kommer att göra i framtiden återstår att se. Men LLM-verktygen har numera bevisat i svart på vitt att de kan hitta buggar i verklig kod som både människor och klassiska buggverktyg missat under lång tid.

Även Aardvark ska ha hittat buggar, varav tio CVE-klassade fel i öppen källkod.

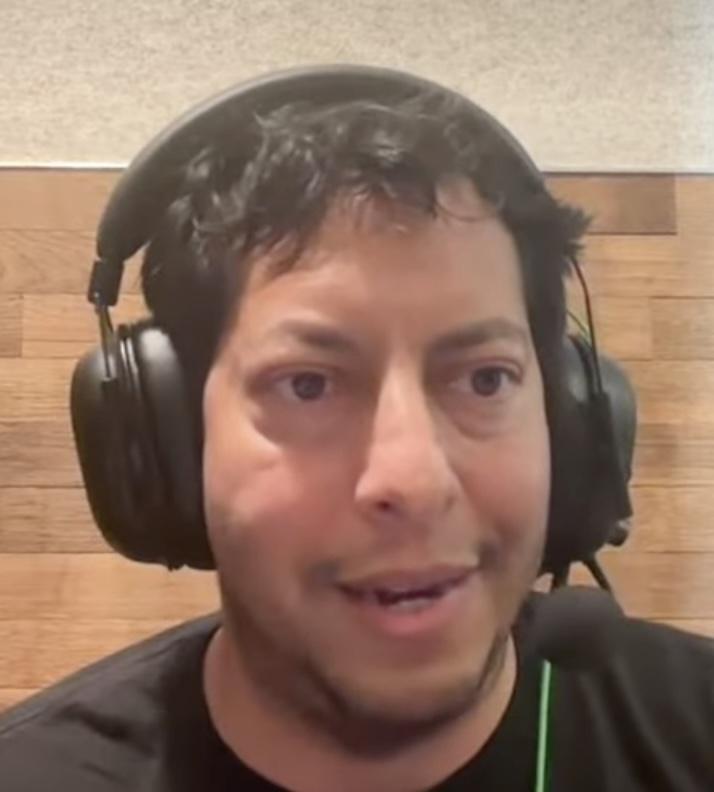

Dave Aitel – en av nyckelpersonerna bakom projektet Aardvark är säker på att LLM-verktyg kommer bli en naturlig del i verktygskedjor för felsökning.

|

| Dave Aitel |

– Om tre månader, om ditt SDLC [Software Development Life Cycle reds. anm.] inte innehåller ett verktyg av det här slaget, då är det trasigt, säger Dave Aitel i pratshowen Three Buddy Problem.

Aardvark betyder jordsvin och sådana äter skalbaggar, buggar, om du undrar över namnet. Dave Aitel noterar att Aardvark inte nödvändigtvis behöver kunna hitta buggar som människor inte skulle kunna hitta på egen hand.

– Men den kanske kan hitta buggar som är för dyra att hitta på andra sätt, eller som människor är för lata för att leta efter. Och det är ju också bra.

Aardvark är ganska tungrott. Det är ickederministiskt, liksom andra LLM-verktyg, och det kan ta flera körningar innan den snubblar över en bugg värd att rapportera. Dave Aitel hoppas att det färdiga verktyget kommer att bli enklare att använda. Det är därför han bjuder in betatestning, för att få hjälp att putsa verktyget.

– Jobbet är inte klart bara för att vi är i beta, konstaterar Dave Aitel.

Buggar kostar pengar. Företag kan idag betala ut tiotusentals dollar som belöning till den som rapporterar en bugg – för att den kan kosta företaget betydligt mer oupptäckt.

Open AI trycker på cybersäkerhet i sin lansering. Men buggar kan kosta pengar även på andra sätt. Dave Aitel tror Aardvark redan kan ha sparat Open AI miljoner dollar på fynd i Open AI:s egen kod. Open AI gör tunga beräkningar när det tränar sina LLM-neuronnät.

– Det har varit buggar som kanske inte varit säkerhetsrelaterade men som skulle ha orsakat stabilitetsproblem i delar av systemet, till exempel under träningskörningar.

– En träningskörning är dyr. När den kraschar kan det ta ett helt ingenjörsteam en vecka att reda ut orsaken. Om Aardvark hittar den sortens buggar i förväg sparar det både den veckan och den misslyckade körningen – vilket kan motsvara miljonbelopp.

Aardvark använder GPT5, samma LLM som senaste versionen av ChatGPT. Så du skulle i princip lika gärna kunna använda Chat GPT som Aardvark.

Men Open AI har skapat en process åt dig som styckar upp koden i lagom munsbitar och kartlägger beroenden. Så att du till slut förhoppningsvis bara behöver peka på en kodbas som Aardvark ska bevaka. Och så tar Aardvark hand om resten på eget initiativ. Varje gång du gör en ändring i projektets kod vaknar Aardvark till liv och gör en ny granskning.

Projektet Aardvark tog fram egen statistik som säger att mellan 1,2 och 2 procent av alla commits (kodändringar) introducerar en kvarstående bugg. Skattningen baserades på säkerhetskritisk öppen källkod skriven i C och C++.

Aardvark kommer till och med att föreslå en fix, skapad av Open AI:s egen LLM-baserade kodgenerator Codex. Och provköra fixen i en sandlåda. Och bedöma buggens allvarlighet – hur hårt Aardvark ska slå i larmklockan.

Alla buggar Aardvark hittat har granskats av en utvecklare innan de skickats vidare. Ingen vill slösa tid på att rapportera hallucinerade sårbarheter.

Open AI ger sig in på ett område där det redan finns ett antal hoppfulla aktörer. Det svenskledda öppenkodsprojektet Curl har under hösten knutit kontakter med flera av dem, och mejlade även Aardvark så fort nyheten om betetestet släpptes i fredags.

Vid lanseringen av Aardvark uppstod genast en oro för att jätten Open AI skulle sluka marknaden.

|

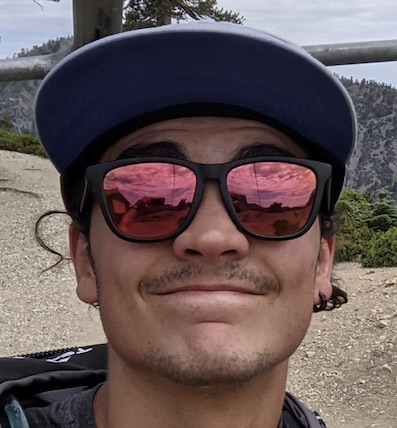

| Fabio Gritti |

– De N startupföretag som gör exakt samma sak kommer att få det väldigt svårt om de inte kan visa ett verkligt övertag jämfört med Aardvark, säger Fabio Gritti till Elektroniktidningen

Han leder Shellphish, ett team akademiska säkerhetsforskare som just nu startar ett företag kring LLM-baserad felsökning.

– Som du nämnde hjälper både pengarna och ”Open AI-stämpeln” enormt med att få genomslag, även om liknande lösningar har funnits de senaste åren.

– Med det sagt ser jag inte den här nyheten som något fundamentalt annorlunda än vad Google gör med Big Sleep och CodeMender.

Han syftar på det stora projektet på AI-buggjaktsområdet, Googles forskningsprojekt Big Sleep. Det presenterade i början av oktober Codemender – en buggfixare som vill putsa även fungerande kod, för att sänka risken för att den drabbas av buggar i framtiden.

Fabio Gritti konstaterar att alla verktygen fortfarande är i sin linda.

– Jag tror att Aardvark, Big Sleep och CodeMender löser ett mycket specifikt – och väldigt intressant – problem inom mjukvarusäkerhet, och ribban ligger definitivt högre nu. Men det finns många andra problem som de här systemen fortfarande är långt ifrån att kunna hantera.

Stanislav Fort på europeiska uppstarten Aisle välkomnar fler aktörer inom LLM-baserad cybersäkerhet. Det kan förmodas pågå en kapprustning mellan onda och goda aktörer. Att Open AI engagerar sig är ytterligare ett bevis på att tekniken fungerar.

|

| Stanislav Fort |

– Jag tycker att Aardvark – precis som Google Project Zero och vissa initiativ från DeepMind – är ett fantastiskt kvitto på det område vi själva arbetar inom.

– Det är faktiskt oerhört spännande för oss att stå öga mot öga med OpenAI och Google – det händer inte ofta att ett litet, ungt företag som Aisle, dessutom med bas huvudsakligen i Europa, får möta dessa jättar på jämlik nivå!

Så gräver Aardvark fram buggarAardvark letar efter sårbarheter, bedömer hur de kan utnyttjas, prioriterar efter allvarlighetsgrad och föreslå patchar. Den undersöker om det introduceras nya dataflöden, nya värden som måste skyddas även på andra platser i koden? Aardvark använder inte traditionella analysmetoder som fuzz-testning eller komponentanalys, utan utnyttjar språkmodells-driven logik för att förstå koden och hitta svagheter. När en kodbas kopplas in första gången skannas även dess historik. Aardvark förklarar och kommenterar sina fynd. När en möjlig sårbarhet hittats försöker Aardvark bekräfta den i en sandlåda. OpenAI Codex skapar patchar. Varje fynd får en patch som kan granskas och godkännas med ett klick. Utöver säkerhetsluckor hittar Aardvark logiska buggar, ofullständiga fixar och integritetsproblem. |

Illustration: Jan Tångring