Det var inte länge sedan det hajpade elektronikområdet artificiella neuronnät var dödförklarat. Nu tycks det blåsa liv i en annan idé vi gett upp hoppet om – optiska beräkningar.

Det var inte länge sedan det hajpade elektronikområdet artificiella neuronnät var dödförklarat. Nu tycks det blåsa liv i en annan idé vi gett upp hoppet om – optiska beräkningar.

I sextio år har vi misslyckats med att bygga en användbar optisk dator. Så det finns en fullt begriplig skepsis mot idén.

Problemet är att optiska beräkningar aldrig lyckats leverera en komplett generell dator. Men artificiella neuronnät är inga generella datorer. Därför är det inte orimligt att hoppas att något av ett flertal uppslag till optiska neuronnätsacceleratorer faktiskt kommer att kunna lyckas.

De gamla förhoppningarna finns kvar om betydligt högre prestanda och energieffektivitet hos optiska än elektroniska beräkningar.

Artificiella neuronnät är sedan ett par år elektronikvärldens hetaste nisch. Kring 2011 började underområdet deep learning ge överlägsna resultat för mönsterigenkänning i bland annat bild och ljud. Det satte en snöboll i rullning och idag görs gigantiska satsningar jorden runt på forskning och utveckling.

Branschen tror nämligen att artificiell intelligens baserad på djup maskininlärning är något som kommer att behövas precis överallt.

Denna artikel har tidigare publicerats i magasinet Elektroniktidningen. För dig som jobbar i den svenska elektronikbranschen är Elektroniktidningen gratis att prenumerera på – våra annonsörer betalar kostnaden. Denna artikel har tidigare publicerats i magasinet Elektroniktidningen. För dig som jobbar i den svenska elektronikbranschen är Elektroniktidningen gratis att prenumerera på – våra annonsörer betalar kostnaden.Här tecknar du prenumeration (länk). |

Acceleratorer för djupa neuronnät har integrerats i molnservrar, mobilprocessorer och självkörningsdatorer från bland annat Google, Apple och Tesla vilket dramatiskt höjt deras AI-prestanda. Det är snarast svårt att hitta en processor- eller styrkretsmakare idag som inte vill integrera neuronnät.

Gott om neuronkärnor finns för licensering, och dussintals uppstartsföretag arbetar på egna kretsar. Nu dammar entreprenörerna även av den gamla idén om optiska beräkningar.

Under åratal av forskning gick det inte ens att få fram en realistisk optisk transistor. Utan transistorer blir det inga NAND-grindar eller motsvarande komponent som krävs för att implementera generell digital logik och en komplett dator.

Men en inferens i ett neuronnät är i grunden bara en sekvens matrismultiplikationer – inga iterationer, inga val, ingen minneslagring.

Operationen behöver inte ens göras digitalt så alla typer av analoga datorer har plötsligt blivit intressanta. Att förstärka är att multiplicera och att ackumulera är att summera, för att ta ett exempel.

I den optiska domänen kan vi leka med egenskaper som ljusstyrka, pulslängd, frekvens och fasförskjutning. För var och en av dessa har forskarna upptäckt möjligheter att implementera matrismultiplikation – neuronnätens grundläggande operation. Förhoppningen är som förr att optiska beräkningar ska kunna höja prestanda och sänka strömförbrukningen dramatiskt.

De optiska och elektroniska domänerna är fundamentalt olika på spännande sätt. Å enda sidan skulle det krävas chips i storlekar som fotbollsplaner för att i en viss optisk teknik bygga något lika komplext som den senaste generationens elektroniska processorer med miljarder transistorer.

Å andra sidan har optik egenskaper som ur en elektrons perspektiv är närmast magiska – som att kunna ockupera samma fysiska utrymme utan att störa varandra och till och med kanske utföra samma operationer parallellt på samma fysiska komponent i olika frekvenser.

Alla de nya optiska uppslagen stöder inte alla sorters neuronnät, för till exempel deep learning som bygger på gigantiska, svårtränade typer av neuronnät.

Men även enkla klassiska neuronnät har fått en renässans. Dessutom är deep learning fortfarande såpass färskt att ingen vet vart utvecklingen kommer att gå, ens i stora drag. Det finns alltså goda skäl att fortsätta följa upp alla trådar.

Utöver matrismultiplikation behöver en optisk neuronaccelerator kunna konvertera mellan den digitala och den optiska domänen. Och den behöver kunna applicera den tröskelfunktion som appliceras mellan varje matrismultiplikation för att undersöka om en neuron gjort ett intressant fynd i sitt indata.

Acceleratorn kan också behöva diverse putsning och stöd för att skydda signalerna mot brus, temperaturvariation, överhörning och annat som hotar upplösning och stabilitet.

Den behöver också signaltransport som inte läcker. Och vill den vara programmerbar behöver den skrivbart minne, exempelvis fasförändringsteknik lånad från skrivbar DVD.

Den utveckling av optoteknik som sker inom datakommunikationsområdet ger en utmärkt grund att stå på – också detta kan vara en faktor bakom att område tycks börja bubbla just nu. Optochips har under de senaste kanske fem åren blivit billig teknik att göra både prototyper och volymproduktion i, bland annat genom att utnyttja äldre processnoder.

Ytterligare en komponent är tekniköverföring från kvantdatorforskning – se där, ytterligare ett till synes hopplöst område som plötsligt kan börja göra nytta.

I forskningstidskrifter som Nature och Science ploppar sedan flera år regelbundet upp nya koncept för optiska neuronacceleratorer. Men det finns ännu långt ifrån ett myller av uppstartsföretag.

Utöver de MIT-knoppningar vi berättar om i artikeln nedan, har Elektroniktidningen hittat ytterligare tre aktuella bolag som stakat ut en väg till skarpa optiska neuronnätsprokter: Fathom som gör optiska neuronnätsberäkningar i linser, Lighton som gör optisk preprocessning före neuronnätsberäkningar och Optalysys som som gör fouriertransformationer genom att skapa diffraktionsmönster i mikrodisplayer.

Det sistnämnda ett av de äldsta exemplen på optiska beräkningar, och FFT är en vanlig förbehandling innan data slussas vidare till neuronnät – bland annat – Optalysys har även andra tillämpningar.

Artificiella neuronnät och optiska beräkningar har haft varsin vinter i kylig skepsis från omgivningen. Nu går de kanske mot en vår tillsammans.

Neuronnät på noll energi En optisk komponent avsedd för kvantdatorer öppnar möjligheten för en neuronnätsaccelerator med svindlande teoretiska prestanda. Forskarteamet splittrades snabbt i två avknoppningsbolag som båda presenterat kretsar och i vår fått finansiering, från Baidu respektive Alphabet. En optisk komponent avsedd för kvantdatorer öppnar möjligheten för en neuronnätsaccelerator med svindlande teoretiska prestanda. Forskarteamet splittrades snabbt i två avknoppningsbolag som båda presenterat kretsar och i vår fått finansiering, från Baidu respektive Alphabet.

Det sägs att det som hände var att den färske MIT-doktorn Yichen Shen, satt i publiken när MIT-doktoranden Nicholas Harris presenterade en optisk komponent för kvantdatorberäkningar. Yichen Shen insåg att komponenten egentligen gjorde en matrismultiplikation, vilket är basoperationen i ett artificiellt neuronnät. De gick till labbet och testade, och lyckades göra en konstruktion som fungerande ganska bra.

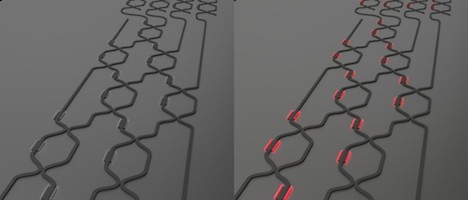

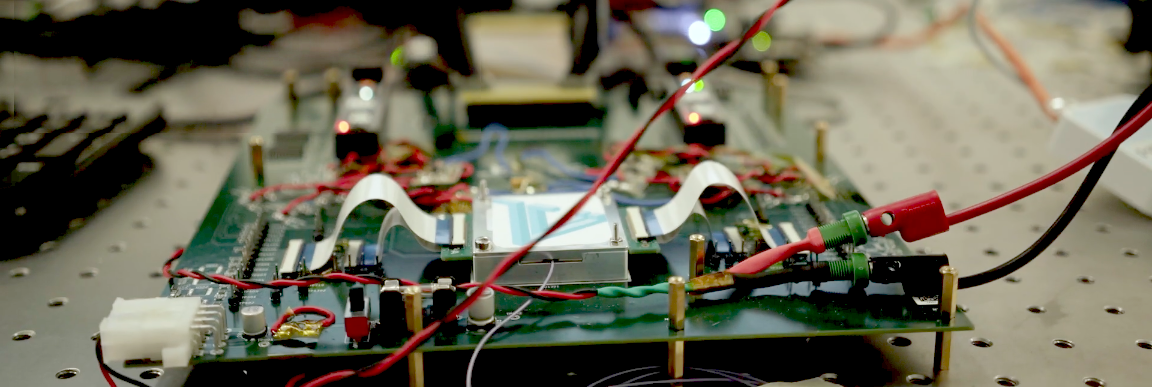

Komponenten är en programmerbar Mach–Zehnder-interferometer (MZI). Sådana mäter fasförskjutningen mellan två ljusstrålar. Grundtekniken uppfanns redan 1891. Ett av de matematiska knepen för att utnyttja MZI:ns fasförskjutningsmätning är att byta ut neuronnätets matriser mot en ekvivalent produkt av bland annat rotationsmatriser. I ett tidigt försök byggde de två forskarna ett litet optiskt neuronnät med två skikt av 56 MZI:er plus 213 termooptiska fasskiftare. De använde det för att separera mellan fyra vokaler i talspråk. Experimentet publicerades i den ansedda tidskriften Nature. I artikeln tror forskarna att det är bandbredden på ingången som sätter gränsen för den teoretiska prestandan. Kan du leverera indata i 100 GHz gör kretsen snällt hundra miljarder inferenser per sekund. Och utan att dra någon energi alls. Inte för själva matrismultiplikationerna i alla fall. Energin i digital logik växer kvadratiskt med dimensionen på matriserna så ju större nät, desto större skillnad skulle MZI-acceleratorn göra. Den skulle vara upp till tio miljoner gånger effektivare i de dimensioner som gäller för typiska deep-learning-problem, enligt forskarna. Energi går åt till att trigga fotodetektorer och driva den mättnadsfunktion som implementerar tröskelfunktionen mellan matrismultiplikationerna. Men den energin växer bara linjärt med dimensionen. Forskarna presenterade även idéer om hur kretsen skulle kunna användas inte bara för inferensdragning utan också för träning. Eftersom den är så extremt snabb och snål blir ett okonventionellt sätt att träna neuronnät plötsligt realistiskt. Efter att de två varit huvudförfattare till artikeln i Nature gick de år 2017 skilda vägar och bildade var sitt bolag. Båda har visat upp provkretsar, och nu i vår fick båda ny finansiering. Nicholas Harris bolag Lightmatter släppte sitt andra provchip i slutet av förra året. Det gjorde uppenbarligen intryck på investerarna som i februari hostade upp 33 miljoner dollar, varav 22 miljoner kom från Alphabet. Lightmatter har idag 23 anställda. Ett skarpt chip för tillämpningar i moln och superdatorer är på väg. Yichen Shens bolag Lightelligence visade i april upp ett prototypchip med prestanda som beskrevs som motsvarande en persondator från millennieskiftet. Nästa krets ska ligga i nivå med dagens digitala AI-acceleratorer och nästnästa ska lämna den digitala domänen i dammet bakom sig. Lightelligence tror att dess första tillämpningar blir i servrar – i allt från de stora molnen till det företagets eget lokala serverrum. Acceleratorn ska levereras på ett PCI Expresskort och företaget säger sig lägga stora utvecklingsresurser läggs på mjukvaran för att göra sig kompatibelt med AI-standardramverk som Tensorflow och Caffe. Företaget har 20 anställda i Boston och fick en finansiering ledd av Baidu, på 11 miljoner dollar i februari |