Nästa år lanserar amerikanska Groq en krets för träning av artificiella neuronnät. Grundaren Jonathan Ross och hans vänner utgör åtta av de tio personer som utvecklade Googles motsvarande krestar TPU och TPU2.

Nästa år lanserar amerikanska Groq en krets för träning av artificiella neuronnät. Grundaren Jonathan Ross och hans vänner utgör åtta av de tio personer som utvecklade Googles motsvarande krestar TPU och TPU2.

Google var långt före sina molnkonkurrenter med att bygga neuronnätskretsar för servrar. De används för neuronnätsträning och neuronnätsinferens och de spar in några serverhallar åt Google när de accelerererar AI-tolkningen av din röstinmatning i Android, bland annat.

Men nu har gänget som utvecklade TPU dragit vidare och grundat ett eget företag, Groq. Det är i färd med att ta fram en egen neuronkrets.

Den ska vara dubbelt så snabb som TPU2 och den ska presenteras nästa år, enligt företagets webbplats.

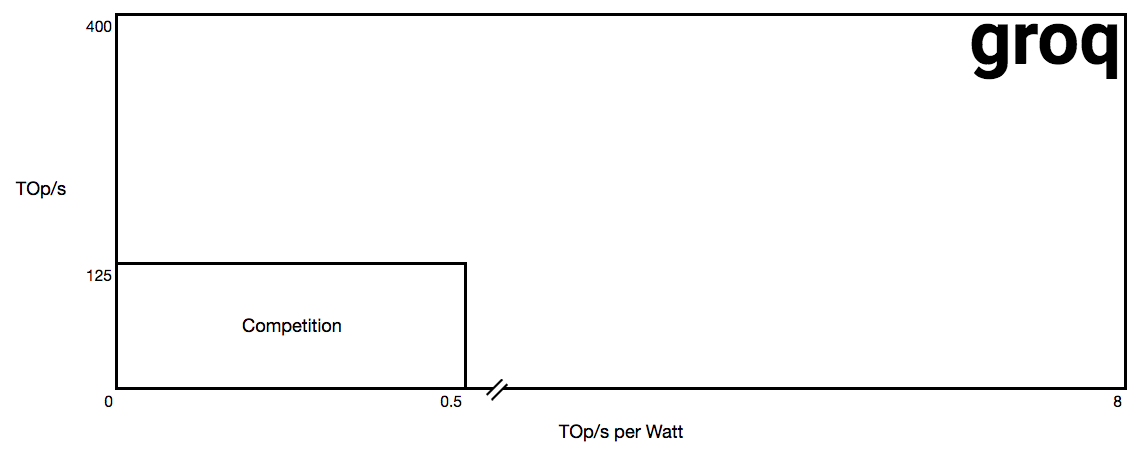

Företagets webbplats består av ett diagram som jämför dagens konkurrens med det som Groq tänker leverera. Se bilden ovan. Observera att x-axeln i diagrammet är bruten! Produkten utlovas att leverera 16 gånger fler operationer per watt än ”konkurrensen”, och inte bara tre som det ser ut visuellt.

Prestanda per chip anges i diagrammet till 400 biljoner operationer per sekund (400 teraops) och effektiviteten till 8 teraops per watt.

Groq använder huvudsakligen det funktionella språket Haskell för sin utveckling, och annonserar efter personal med kunskap i detta.

Enligt tidningen Electronic Design har Groq ett startkapital på 10,3 miljoner dollar.

Electronic Design beskriver Groq som en utmaning mot främst Nvidia och dess neuronnätstrimmade grafikchips, men tidningen nämner även Intel, Wave, Graphcore och Cerebras.

Den sistnämnda är ny för Elektroniktidningens läsare. Företaget sägs enligt en artikel i Forbes utveckla en krets för träning av artificiella neuronnät.

Cerebras har lyckats samla på sig 110 miljoner dollar i investeringar, och värderas till 860 miljoner dollar.