Japanska Fujitsu tränade ett neuronnät på 74,7 sekunder där den tidigare bästa träningsalgoritmen behövt 30 sekunder mer på samma hårdvara.

Japanska Fujitsu tränade ett neuronnät på 74,7 sekunder där den tidigare bästa träningsalgoritmen behövt 30 sekunder mer på samma hårdvara.

Fujitsu har trimmat en algoritm som är öppen källkod att klämma in fler beräkningar i grafikprocessorna. Det som Fujitsu berättar är att algoritmen anpassar inlärningshastigheten allteftersom inlärningen fortskrider, utan att kompromissa med noggrannheten.

|

|

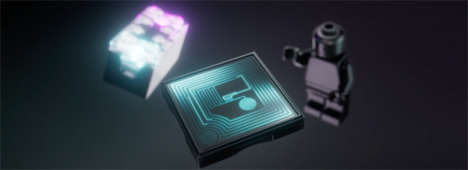

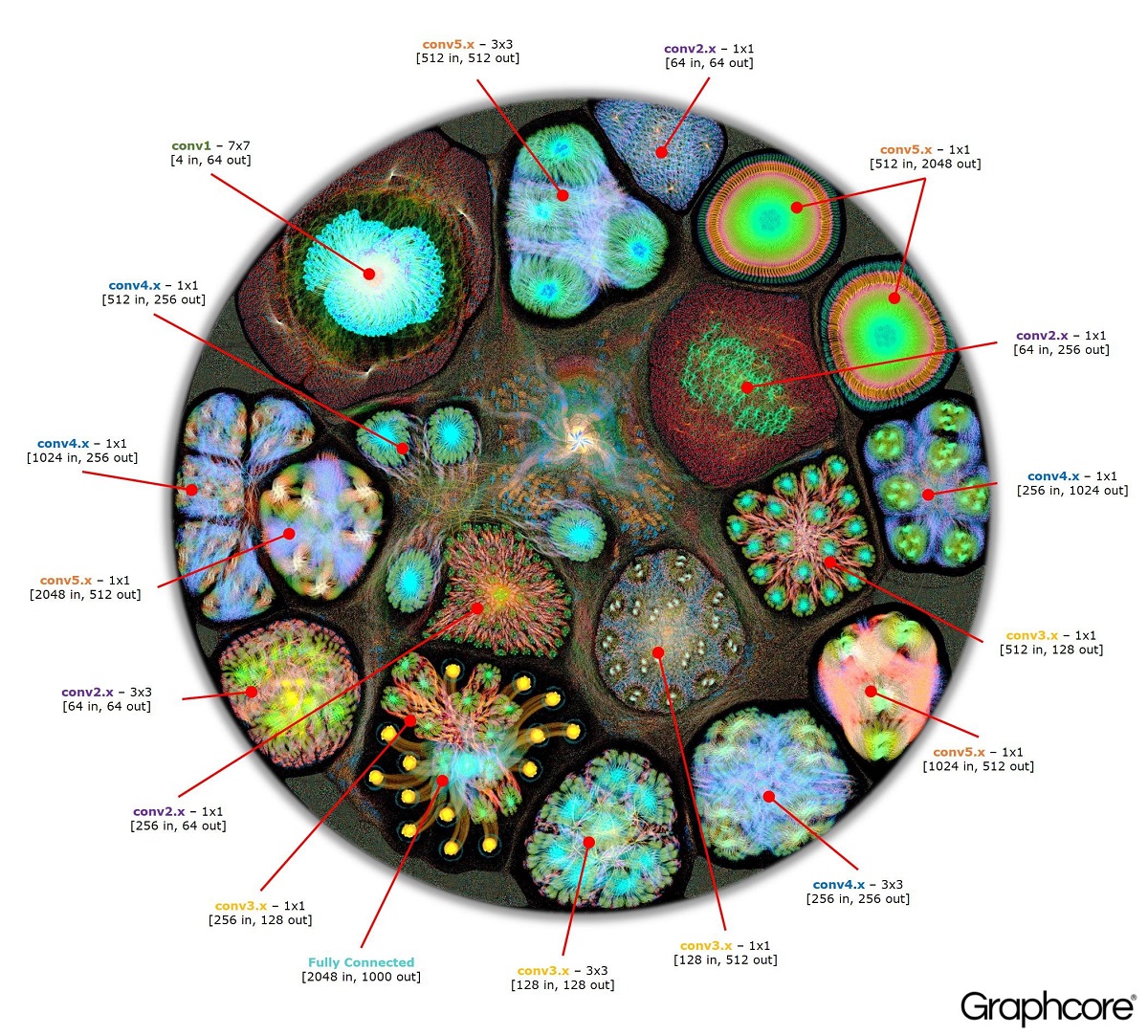

Brittiska Graphcores utplattade visualisering av Resnet-50 och dess 26 000 000 parametrar.

Några av de 1,2 miljoner träningsbilderma, 50 000 valideringsbilderna och 150 000 testbilderna i ILSVRC2012. |

Neuronnätet i fråga heter Resnet-50. Det är ett standardnät som används för bildigenkänning. Träningen av nätet består i att mata det med bilder och att steg för steg finjustera dess cirka 26 miljoner parametrar i 177 skikt att bli bättre och bättre på att känna igen dessa bilder.

Träningsbilderna hämtas från en mapp märkt ”ILSVRC2012” vars innehåll bestämdes år 2012 till en tävling kallad ”ImageNet Large Scale Visual Recognition Challenge”. Kombinationen av ILSVRC2012 och Resnet-50 är ett inofficiellt prestandamått på djupinlärningsalgorimer och -hårdvara.

Algoritmerna kördes på 2048 stycken grafikkort i molnfarmen ABCI (AI Bridging Cloud Infrastructure) som Fujitsu levererat till japanska forskningsinstitutet AIST (National Institute of Advanced Industrial Science and Technology).

Bilden ovan på Resnet-50 kommer från Graphcore som gör de snyggaste visualiseringarna av djupa neuronnät.