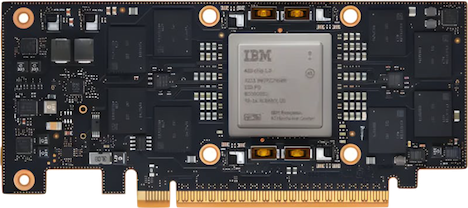

En processor för träning och användning av djupa artificiella neuronnät – det har utvecklats på amerikanska IBM och släpps nu på ett PCI Expresskort.

En processor för träning och användning av djupa artificiella neuronnät – det har utvecklats på amerikanska IBM och släpps nu på ett PCI Expresskort.

Den är ”snabbare än en cpu” enligt IBM i en pedagogisk presentation riktad mot allmänheten.

Det här är företagets första AIU, som IBM kallar den, Artificial Intelligence Unit. Den har utvecklats under fem år.

IBM använder en egen teknik för att optimera beräkningen av skalärprodukter, kallad approximate computing. Neuronnätskretsar är huvudsakligen acceleratorer för matrisalgebra med vad som kallas för en skalärprodukt som grundläggande operation.*

Approximate computing beskrivs i en rapport publicerad 2019. Den ska bland annat handla om att växla mellan 32-bitars flyttal och olika sorters åttabitarsformat, både heltal och flyttal.

23 miljarder transistorer och 32 beräkningskärnor finns på chipet. De 32 kärnorna är samma som tidigare används i IBM:s existerande processor Telum, men då bara i en kopia. Telum tillverkas dessutom i 7 nm-krets och AIU i 5.

IBM har monterat chipet på ett PCI Expresskort så att du kan plugga in den som accelerator i vilken dator som helst.

Den idag vanligaste typen av acceleratorer för neuronnät, i synnerhet för träning, är neuronnätsoptimerade grafikkort från Nvidia.

Google är pionjären på området AI-serveracceleratorer och byggde sin första redan år 2016. Den kan du dock inte köpa fysiskt utan bara använda via Googles molntjänster.

FOTNOT

* Jag försöker hitta en referens i Wikipedia som förklarar hur skalärprodukt (dot product) hänger ihop med artificiella neuronnät, men misslyckas. Det verkar som om matematiska purister inte erkänner detta. Wikipedia refererar inte med ett ord till artificiella neuronnät under vare sig Linjär algebra, Tensor, Matris, Skalärprodukt eller Vektor.

Läsaren omdirigeras (se denna diskussion) till Array data type – som (förstås) inte heller det nämner nåt om neuronnät utan länkar tillbaka till tensor och vektor när det börjar brännas. Så varken datavetare eller matematiker vill kännas vid artificiella neuronnät? Uppslagsordet Mathematics of artificial neural networks är rörigt och nämner (som hämnd?) inte skalärprodukt.

Så har IBM:s arbete med att optimera ”skalärprodukter” för artificiella neuonnät varit förgäves? Nej. Här (länk) är en genomgång som förklarar hur skalärprodukter och artificiella neuronnät hänger ihop. Med undantag för att operatorsymbolen för skalärprodukt, ”∙”, har tappat höjd och blivit en helt vanlig punkt, ”.”.