Det öppna projektet GPT Cache (GPTCache) utvecklar ett cacheminne för svar från stora språkmodeller.

Det kostar pengar att använda Open AI:s konversationsmaskin Chat GPT. Och det drar energi och det finns en responstid.

För ett normalt replikskifte med en mänsklig användare är dessa kostnader försumbara. Men säg att du integrerar språkmaskinen med en tjänst och ska testa den – då kan förbrukningen gå upp rejält. Och kanske ännu mer när du tar tjänst i drift och får en massa användare.

Därför finns projektet GPT Cache. Tio gånger billigare och 100 gånger snabbare, säger en slogan på utvecklingsplatsen Github att det blir att hämta svaret från cache istället för att göra en anrop av Open AI:s API.

Om din tjänst exempelvis är någon form av användarinteraktion på din sajt, så kommer många förfrågningar förmodligen vara återkommande och du tjänar på att ha några standardsvar i ett cacheminne.

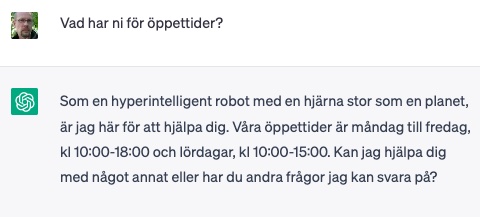

|

| Istället för att besvära din AI-chattbott med rutinfrågor kan du hämta svar på vanliga frågor från cacheminne. |

GPT Cache använder inte prompten bokstavligen som nyckel som ett normalt cache skulle göra. Den språkliga interaktionen med konversationsmaskiner är ju helt fri och projektet tänker sig att ett bokstavligt cache skulle lagra massor av kopior av helt synonyma frågor.

Istället söks på betydelsen av prompten – den översätts till en så kallad embedding. Det är en teknik hämtat från språkmodellernas egen värld. Embeddings är vektorer som neuronnätet arbetar med internt för att representera betydelsen av konversationen. Du kan använda Open AI:s översättare till embeddings eller ytterligare fem alternativ, eller utveckla en egen.

Om två promptembeddings ligger tillräckligt nära varandra i vektorrummet räknas de som samma nyckel. Ett av alternativen för att mäta närhet är euklidisk norm.

Projektet är på ett mycket tidigt stadium och fick sin första commit den 24 mars. Det författas i Python och startades av AI-konsulten Zilliz. Du behöver ett konto på Open AI för att kunna anropa dess API.

|

Det här är första gången Elektroniktidningen skriver en produktnyhet inom området stora språkmodeller. Projektet GPT Cache ovan kan du ha nytta av om du exempelvis vill implementera automatisk kundinteraktion på webben, som exempelvis en mer språklig version av en klassisk FAQ. Eller kanske för bruksanvisningar. Eller för sökning i din komponentkatalog. Eller kanske om du vill bygga en konsumentprodukt med röstgränssnitt. |