EMBEDDED WORLD Japanska Edgecortix gästade mässan med ett AI-chip förberett för att köra stora språkmodeller lokalt istället för att delegera operationerna till molnet.

EMBEDDED WORLD Japanska Edgecortix gästade mässan med ett AI-chip förberett för att köra stora språkmodeller lokalt istället för att delegera operationerna till molnet.

Företagets namn avslöjar tillämpningen: Edgecortix. Företaget grundades för fem år sedan av sin vd Sakya Dasgupta.

Mjukvaran till chipet utvecklades ovanligt nog innan chipet.

|

| Tim Vehling |

– Det första vi utvecklade var en kompilatorstack vid namn Mera. Till den utvecklade vi en IP-kärna, berättar säljchefen Tim Vehling som är amerikan baserad i Kalifornien men talar flytande japanska.

Det betyder att Indien fick vänta på Japan. Av det dryga sextiotalet anställda sitter chiputvecklarna i Indien och mjukvaruutvecklarna i Japan, Tokyo.

Kombinationen av en kompilator och AI-kärna för FPGA-implementering blev företagets första produkt.

– Men vi insåg att en FPGA hade för klen prestanda och bestämde oss för att utveckla ett chip.

Kompilatorn är inte gift med chipet – Sakura – utan den är heterogen och ska kunna kompilera för den hårdvara du har i form av cpu, FPGA eller asic.

AI-acceleratorn är rekonfigurerbar under drift.

– För varje klockcykel kan vi konfigurera – tilldela minne och resurser.

– För varje klockcykel kan vi konfigurera – tilldela minne och resurser.

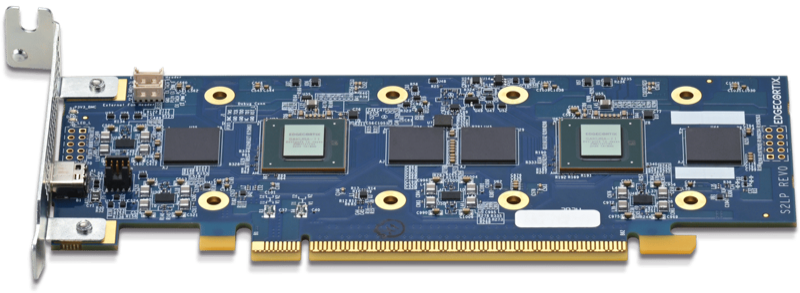

Sakura kommer just nu ut i provexemplar i sin andra generation i 12 nm. Edgecortix visar upp det på M.2-kort och PCI Expresskort. Volymproduktion kommer andra halvåret.

Korten finns med 16 eller 32 Gbyte minne och en bandbredd på 68 GB/s.

– För 3–4 år sedan var det CNN-nät som gällde i AI-världen, för datorseende och objektklassificering. Det som räknades var teraops, medan minne var mindre kritiskt.

– Idag är det transformer-modeller som gäller, LLM. De har miljarder parametrar.

Molnets jättemodeller är utom räckhåll, men även för edgemodeller talar man om sju, åtta miljader parametrar. Edgecortix kort klarar upp till tio. Prislappen startar kring 300 dollar.

Språkmodeller kommer att ersätta klassiska användargrässnitt som tangentbord. Integritet och snabbhet är fördelarna mot att lägga rösttolkningen i molnet.

Lokalitet kan vara ett direkt krav i specifikationen av ett system, exempelvis för att uppkopplingen på fabriksgolvet inte duger.

Edgecortix kommer att köra CNN-nät och LLM-nät parallellt.

– De flesta av våra kunder vill ha både-och. Det är lite överraskande.

– Tänk dig en produktionsmiljö, till exempel. Vision kommer att upptäcka och spåra objekt och språkmodellen kommer att berätta för operatören vad som sker.

– Eller att operatören går fram till maskinen och frågar om det varit någon säkerhetsincident senaste timmen och i så fall vad som hände?

Kunder finns inom robotik, industriell tillverkning, smarta städer, luftfart och försvar.

Konkurrens?

– Vi har två typer av konkurrenter. Det finns dels ett antal AI-chipstartupper – ett par, tre av dem finns här på mässan – men de är optimerade för CNN. De är sent ute.

– Dels finns Nvidia. Det är dem vi blir jämförda med när vi pratar med pontiella kunder.

Elektroniktidningen frågar om ”hotet” från en utveckling där prestanda som krävs för att köra bra språkmodeller fortsätter minska. Som när kinesiska Deep Seek släppte en chattbot som fick Nvidias börskurs att rasa.

Nästa chock blir kanske när modeller inte behöver så mycket minne som ni har?

– Det skulle vara en intressant utveckling. Men jag tror det är svårt, med tanke på hur modellerna fungerar. Du skulle få ett väldigt litet kontextfönster. Det finns en undre gräns, med tanke på hallucinationer och fake-information.

– Men visst, man vet inte med AI världen – det händer mycket och det händer snabbt – nya modeller och arkikekturer – nya angreppsssätt. Det är verkligen en spännande marknad!

Företagets finansiering kommer från Renesas – som även är tidig kund och licenserar kompilatorn.

Dessutom lyckades Edgecortix i november att få ett statligt bidrag på 270 miljoner kronor för att utveckla en ny generation av chipet. Prestandan blir 7–8 gånger högre.

Det blir en chiplet – Risc V-baserad – som dessutom ska kompletteras med ytterlighare en chiplet som är en radiodel för RAN, nästa generation mobilnät.

– Den här gången optimerar vi för prestanda snarare än strömförbrukning

AI är hett inom Ran. Det kommer att användas för att optimera radionätets prestanda, exempelvis för att följa rörelser i mobilnätet. Det kräver realtid och låg strömförbrukning men görs hittills idag på cpu:er och FPGA:er.