En stabil implementation av maskininlärning i analog elektronik – det tror sig en grupp IBM-forskare kunna konstruera. Nästa steg är att producera en prototypkrets.

En stabil implementation av maskininlärning i analog elektronik – det tror sig en grupp IBM-forskare kunna konstruera. Nästa steg är att producera en prototypkrets.

Nyckelordet är stabil. Analoga kretsar som implementerar artificiella neuronnät är ingen nyhet. Men de har lidit av ojämnheter i tillverkningen, låg precision och brist på synkronisering.

Kretsen kan användas för träning av artificiella neuronnät.

Detta är en beräkningstung algoritm som idag huvudsakligen utförs i grafikkretsar. Specialsydda neuronnätkretsar är under utveckling för att göra processen effektivare, men alla sådana kretsar som rapporterats hittills har varit implementerade i klassisk digital teknik.

IBM-forskarna har gjort simuleringar och anser sig ha bevisat att kretsen skulle bli två magnituder gånger effektivare än en GPU på uppgiften att träna neuronnät. Och detta ska vara en konservativ jämförelse med GPU:ers maxprestanda.

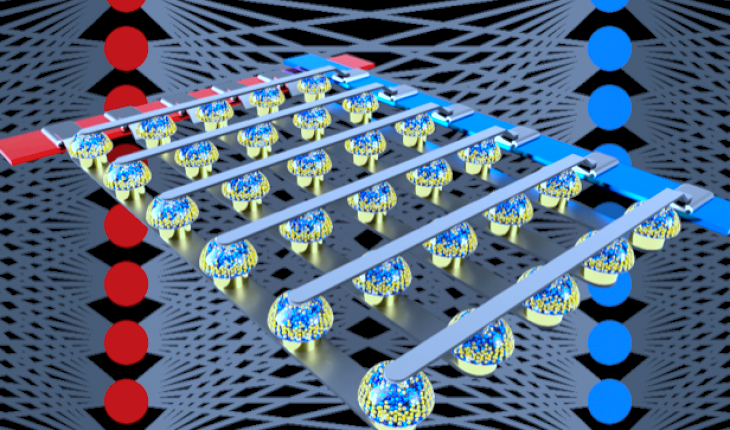

Kretsen består av artificiella synapser – motsvarande kopplingspunkter mellan hjärnceller. Träning innebär att styrkan i dessa kopplingspunkter justeras. De kallas vikter och justeras enligt en algoritm kallad backpropagation.

En operation som krävs är att addera produkten av vikten och ett indatavärde till en summa (multiply-accumulate). Det gör IBM-forskarna genom att strömmar leds genom motstånd och summeras.

Vikterna lagras i kretsen, vilket betyder att flaskhalsen med kommunikation med minne försvinner. IBM kallar kretsen för en analog minnesenhet.

Forskarna presenterar sin teknik i en artikel i tidskriften Nature.

I simuleringar har nätet övat in bild- respektive handstilsdatabaserna CIFAR-10 och CIFAR-100 respektive MNIST och MNIST-backrand, och uppnått samma noggrannhet som ett nät tränat i digital teknik, men på en bråkdel av energikonsumtionen.

PCM-minnet i simuleringen var fysiskt, för att garantera att alla aspekter på den fysiska variationen på kretsen fångades. En av nycklarna till forskarnas resultat är en teknik för att utjämna denna variation.

I reda siffror uppnår forskarna 28 miljarder operationer per sekund per watt och har en genomströmning på 3,6 biljoner operationer per sekund per kvadratmillimeter. Detta ska vara yvå magnituder mindre än vad en GPU konsumerar under motsvarande träning.

Två typer av minne används i konstruktionen: integrerade CMOS-kondensatorer för beräkningar och PCM (fasväxlande minne) för lagring.

Artikeln i Nature heter ”Equivalent-accuracy accelerated neural-network training using analogue memory”. Den har 14 författare, samtliga anställda på IBM Research i San Jose, utom en som är på samma institution, men i Zürich.

Nästa steg är att producera en prototyp på IBM Research Frontiers Institute.

En annan utvidgning är att testa tekniken på återkopplade stora nät av typen GRU (Gated Recurrent Unit) och LSTM (Long Short Term Memory).