Google släpper den första asic som stöder träning av djupa neuronnät. Den finns redan i rack i Googles moln och tusen kort är reserverade för forskare gratis, givet att de publicerar sina resultat.

Google släpper den första asic som stöder träning av djupa neuronnät. Den finns redan i rack i Googles moln och tusen kort är reserverade för forskare gratis, givet att de publicerar sina resultat.

Under sin konferens I/O presenterar Google sin andra asic för AI-tekniken djupa neuronnät.

|

|

För ett år sedan presenterade Google den första generationens TPU (Tensor Processing Unit) på samma konferens. Den hade då redan använts i Googles serverfarmar sedan 2015. Du använder den själv i Googles automatöversättning, röstgränssnitt, sökmotor och bildarkiv. Och några rack TPU:er besegrade världens bäste go-spelare i fjol.

TPU1 stöder endast användning av färdigtränade neuronnät, så kallad inferens. TPU2 stöder även träning av nät. Träning är vad man kallar proceduren att programmera djupa neuronnät för en given klassificeringsuppgift, som att identifiera katter i fotografier.

Båda är huvudsakligen acceleratorer för matrismultiplikation.

En teknisk skillnad är att TPU1 använder heltalsaritmetik och TPU2 flyttal. Under träning används flyttal vilket betyder att TPU1 kräver ett konverteringssteg från flyttal till heltal innan det färdigtränade nätet kan användas. Det steget slipper TPU2.

TPU1 kan göra sin inferens ensam. TPU2 används däremot alltid i system vid träning.

Idag görs träning av djupa neuronnät huvudsakligen på grafikkort från Nvidia och det kommer även Google att fortsätta att erbjuda i sitt moln.

Men för egen del flyttar Google stegvis över sin neuronnätsträning från GPU:er till TPU2.

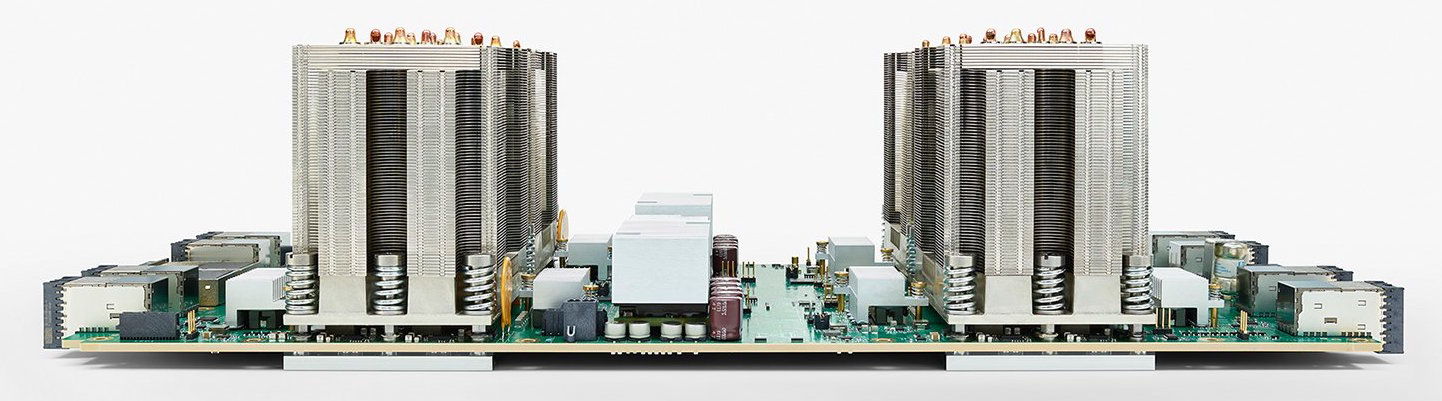

En TPU2-kort innehåller 64 Gbyte RAM och fyra TPU2-chips, och levererar 180 Tflops (180 × 1012 flyttalsoperationer per sekund)

64 TPU2-kort byggs ihop till en ”TPU-pod” genom att de ansluts till varandra i en tvådimensionell torus (ett schackbräde med ett kort i varje ruta anslutet till sina fyra grannar, där även första och sista raden respektive kolumen räknas som grannar). En pod har därmed en total prestanda på 11,5 petaflops.

Enligt Google klår den nya TPU:n Nvidias GPU:er för träning. Google ger som exempel att ett språköversättningsnät som tar en dag att träna på 32 GPU:er, tar sex timmar på ”en åttondels pod”.

Tom’s Hardware räknar ut att TPU-korten har 50 procent högre prestanda för inlärning än Nvidias nylanserade accelerator Tesla V100.

Elektroniktidningen hittar inga siffror om strömförbrukning.

Beräkningskraft för träning av djupa nät är idag en flaskhals för Googles utveckling av AI-tjänster, bland annat för automatöversättningen.

– Vår största träningssystem har inte ens orkat ta sig igenom en sjättedel av de data har vi för vissa kombinationer av språk. Därför byggde vi den andra generationens TPU, säger Googles Jeff Dean till tidningen EE Times.

Om du publicerar dina resultat och åtminstone ”överväger” att publicera dina program som öppen källkod, finns ett ”TensorFlow Research Cloud” med 1000 TPU-kort:er som du får använda gratis.

Google släpper samtidigt version 1.2 av sin programvara för deep learning TensorFlow framework. Det ska göra det lättare att använda deep learning även för den med begränsad erfarenhet av konstgjorda neuronnät.

TPU-molntjänsten kommer att öppnas ”i en nära framtid”.