Google har ett eget AI-chip

Google har använt egenutvecklade asicar med artificiella neuronnät i sina datacenter i ett år. Det avslöjade Googles vd Sundar Pichai igår på den pågående utvecklarkonferens Google I/O.

Google har under det senaste året gjort massiva satsningar på den AI-teknik som kallas deep learning. Den är central bland annat i företagets sökmotor och i företagets språkteknik och utvärderas på snart sagt varje utvecklingsavdelning på Google.

Bakom kulisserna visar det sig att Google också tagit fram en asic för att effektivisera körningen av deep learning-algoritmer. Arbetet med att ta fram en asic inleddes för ”flera år” sedan och blev klart i fjol.

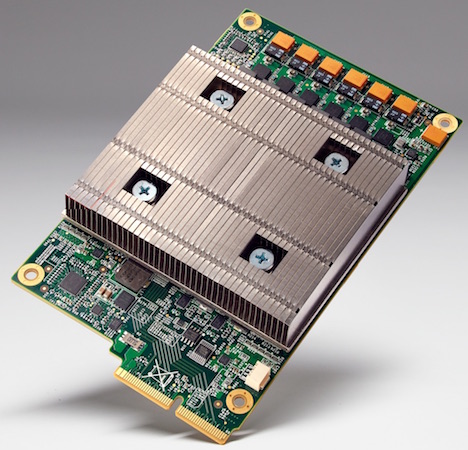

Asicen kallas för en TPU (Tensor Processing Unit) och den är kompatibel med Googles neuronnäts-mjukvara Tensorflow, som Google släppte som öppen källkod i höstas.

En av deep learningteknikens stordåd var att tidigare i år besegra den max rankade go-mästaren Lee Sedol. För den matchen användes bland annat dessa serverrack fulla av TPU-kort. Notera bilden av ett go-bräde på skåpets sida! En av deep learningteknikens stordåd var att tidigare i år besegra den max rankade go-mästaren Lee Sedol. För den matchen användes bland annat dessa serverrack fulla av TPU-kort. Notera bilden av ett go-bräde på skåpets sida! |

TPU-kort sitter idag i racken i Googles datacenter. Chipen används för den mycket resurskrävande träningen av deep learning-algoritmer. Enligt Google är chipen en magnitud effektivare per watt på maskininlärning. Google säger inte vad TPU:erna är en magnitud effektivare än, men idag används typiskt grafikkort från Nvidia för maskininlärning.

Googles TPU använder låg precision i sina beräkningar, till vinsten av högre prestanda och insparade transistorer. Samma knep används i Nvidias deep learning-optimerade GPU-arkitektur Pascal.

TPU:erna används idag bland annat för tjänsten Google Street View och för att prioritera sökresultaten i Google Search.