Efter fem års utveckling har till slut Intels uppköp av Nervana släppt sina första skarpa AI-processorer. Potentiella kunder är alla som vill göra AI i molnet, som Amazon, Facebook och Microsoft.

Efter fem års utveckling har till slut Intels uppköp av Nervana släppt sina första skarpa AI-processorer. Potentiella kunder är alla som vill göra AI i molnet, som Amazon, Facebook och Microsoft.

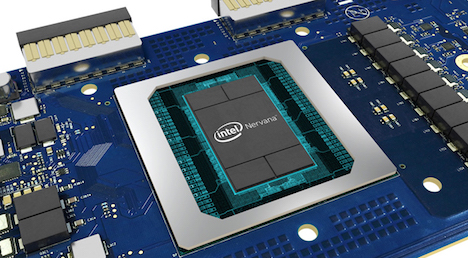

Chipen tillhör en familj kallad NNP (Neural Network Processor) som Intel skaffade sig genom ett uppköp av företaget Nervana år 2017.

Intel har faktiskt redan tillverkat en NNP-processor, men det var en arbetsversion i 28 nm, kallad Lake Crest, som inte var kommersiellt tillgänglig.

Den enda AI-hårdvara Intel haft fram till nu för serverhallen är sina Xeon-cpu:er. Men de kan inte konkurrera prestandamässigt med dedikerade neuronnätsprocessorer. Efter att ha missat AI-vågen köpte Intel för ett par år sedan några AI-bolag för gigantiska belopp, bland dem Nervana vars tidigare vd idag chefar över Intels hela AI-division.

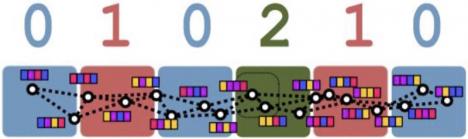

Båda de nya NNP-processorerna kör algoritmer för artificiella neuronnät men är optimerade för träning respektive inferensdragning. Träning innebär att skruva på ett neuronnnäts parametrar tills det konvergerat mot att beräkna en funktion specificerad av exempel på önskade in- och utdata. Att göra en inferens är att applicera ett färdigtränat nät på nya indata.

Neurontränaren NNP-T (Spring Crest) drar upp till 250 watt. Den har en yta av 680 mm2, innehåller 27 miljarder transistorer och tickar i upp till 1,1 GHz. Den har fyra block om 8 Gbyte arbetsminne av typen HBM2-2400.

Neurontränaren NNP-T (Spring Crest) drar upp till 250 watt. Den har en yta av 680 mm2, innehåller 27 miljarder transistorer och tickar i upp till 1,1 GHz. Den har fyra block om 8 Gbyte arbetsminne av typen HBM2-2400.

Neuronberäkningarna sker i 24 stycken block kallade TPC (Tensor Processing Cluster) som har specialinstruktioner för bland annat matrismultiplikation och konvolution. Beräkningarna stöder heltal med en precision på en ynka bit. Dessutom stöds 2-, 4-, 8- och 16-bitars heltal.

Utöver normala 16- och 32-bitars flyttal stöds ett flyttalsformat kallat Bfloat16, populariserat av Google. Tidigare har Nervana använt ett eget flyttalsformat kallat Flexpoint.(*)

På chipet finns 64 banor Serdes HSIO med en aggreggerad bandbredd på 3,58 Tbps. Här finns också sammanlagt 60 MByte cachimme.

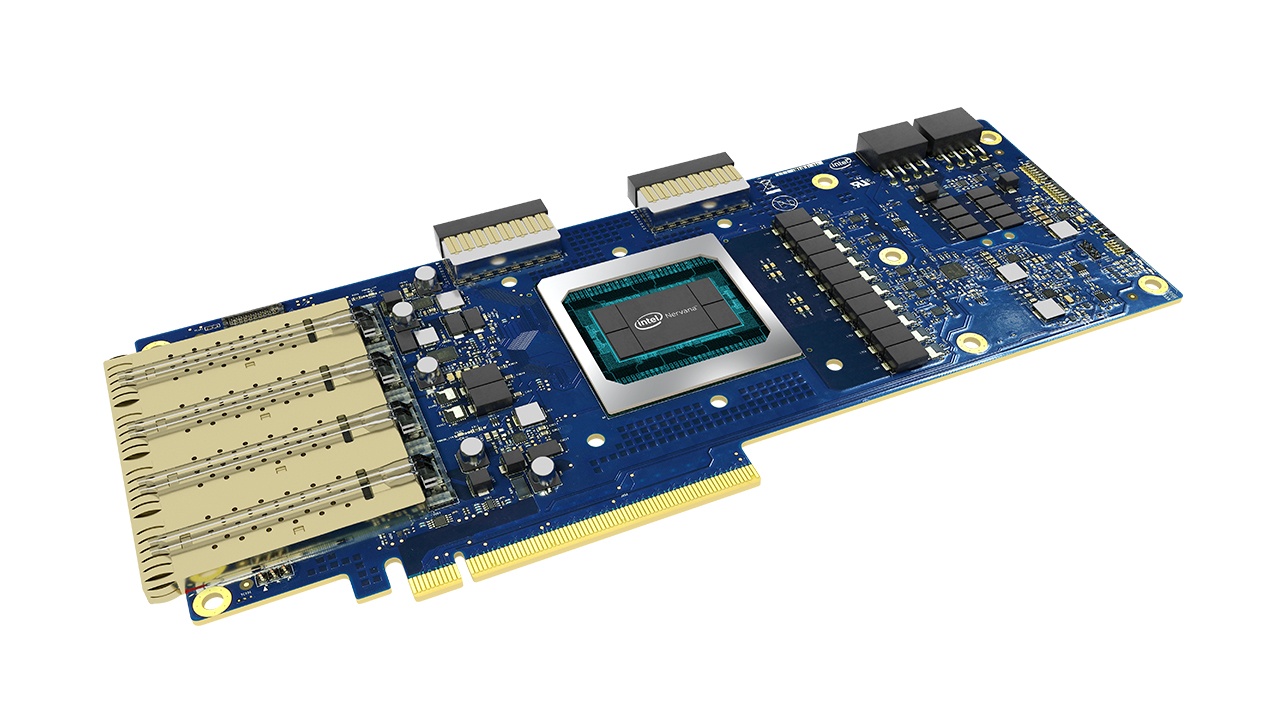

Du köper NNP-T monterad på ett PCI Express 4.0-kort med 16 kanaler. Prestanda är upp till 119 TOPS (biljoner operationer per sekund). Den tillverkas inte av Intel självt, utan av TSMC, i 16 nm CLN16FF+.

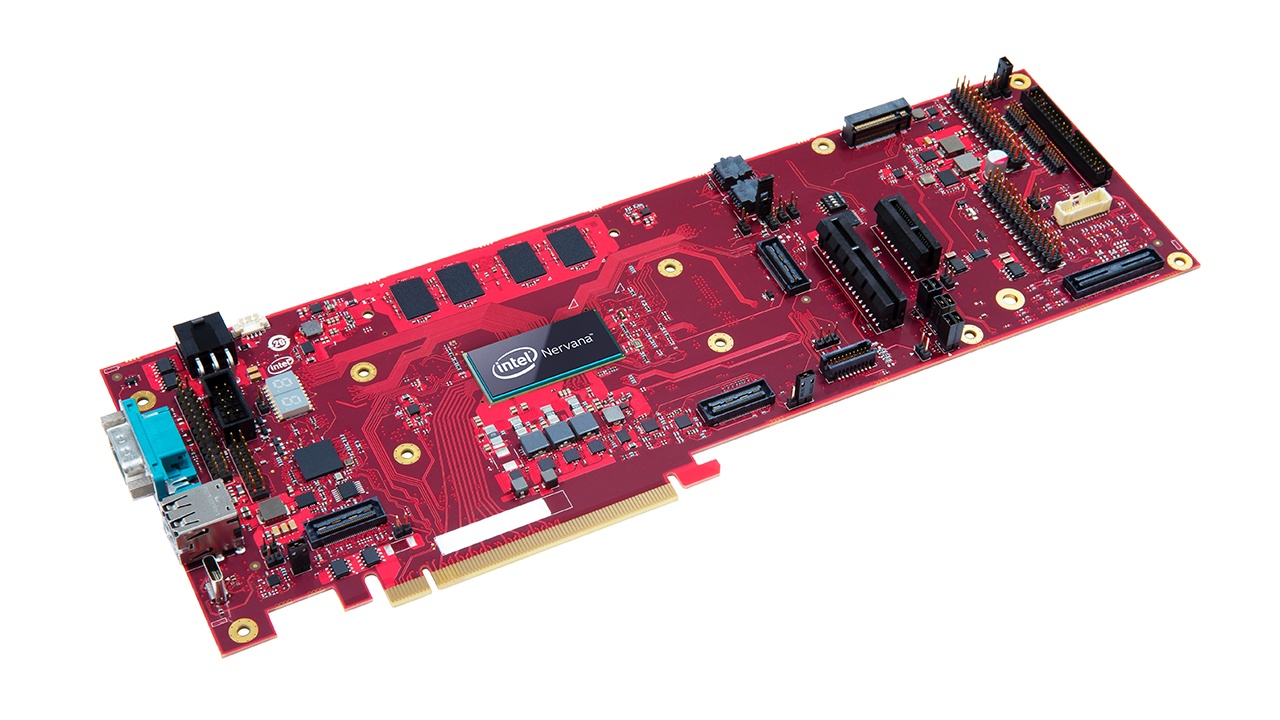

Inferensdragaren NNP-I tillverkas däremot av Intel och i 10 nm.

Inferensdragaren NNP-I tillverkas däremot av Intel och i 10 nm.

Den drar 10–50 watt. Utöver tio (eller tolv) inferensmotorer kallade ICE (inference compute engine) innehåller den två vanliga Intel-cpu:er. Alla dessa tolv (eller fjorton) kärnor hålls cachekoherenta med 14 Mbyte LLC. Inferensmotorerna har dessutom 4 Mbyte SRAM vardera.

Det går att driva beräkningarna två olika vägar genom ICE-inferensmotorerna för att optimera för genomströmning respektive låg fördröjning.

Varje ICE består dessutom av två separata block för att göra inferensdragning på olika sätt. Det ena är en klassisk signalkärna, Tensilica Vision P6 som kallas VPE (vector processing engine). Signalkärnor är fritt programmerbara på klassiskt vis och kan göra andra acceleratoruppdrag än maskininlärning.

Det andra blocket kallas ”Deep learning compute grid” och är hårt optimerat för att räkna på djupa artificiella neuronnät. Det är ett nät av Mac-enheter som gör 4000 Mac-operationer per klockcykel. Prestanda i åttabitars heltal är upp till 4000 MAC/s.

NNP-I kan anslutas till upp till fyra stycken LPDDR4x-moduler om vardera 64 Gbyte. Dit är bandbredden 68 Gbyte/s.

NNP-I kan göra 3600 inferenser/s på neuronnätet Resnet50 samtidigt som den drar 10 watt. Den har en prestanda på 4,8 Tops/W.

Här är Intels egna presentationer av NNP-T (länk) och NNP-I (länk).

FOTNOT

* Det tycks finnas två grupper av forskare på Intel där den ena förespråkar Bfloat16 och den andra Flexpoint. Det här papperet (länk) är skrivet av Intelforskare – men också av några forskare från Facebook – och förespråkar Bfloat. Papperet refererar till ett annat papper från 2017 (länk) som är författat enbart av Intel-forskare, som förespråkar Flexpoint.

Den allra första NNP-processorn (som inte släpptes kommersiellt) stödde Flexpoint. Frågan är varför Intel valt att besvära sig och låta Bfloat16 peta ut Flexpoint ur NNP? Kan Intel ha låtit sin potentiella storkund Facebook bestämma flyttalsformat? Och varför det i så fall? Kanske Facebook vill hålla Intel kompatibel med Google? Som stor potentiell AI-kund har Facebook ända sedan början fått vara med i kravställningen på Nervana. Det finns en diskussion om Intel och dessa två format i kommentarerna till den här Anandtech-artikeln (länk).