Genombrottet för generativt språk får svar i form av en ny våg dedikerade AI-acceleratorer. Neuchip visade upp sin konsumentelektronikmässan i Las Vegas.

Genombrottet för generativt språk får svar i form av en ny våg dedikerade AI-acceleratorer. Neuchip visade upp sin konsumentelektronikmässan i Las Vegas.

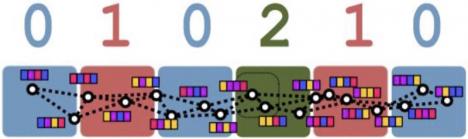

Taiwanesiska Neuchips (grundat 2019) AI-accelerator Evo PCI kommer att finnas med en, två eller fyra stycken chips kallade Raptor när den släpps andra halvåret i år. Varje chip har en prestanda på 200 Tops och drar 55 watt.

Raptor ska vara optimerad mot Transformer-språkmodeller.

Evo PCI har PCIe Gen 5-gränssnitt och demonstrerades på konsumentelektronikmässan CES med ett chip körandes bland annat Metas språkmodell Lama 2 med 7 miljarder parametrar. Den sades även kunna driva Lama 2 med 13 miljarder parametrar.

Evo innehåller 32 Gbyte LPDDR5-minne. Minnesbandbredden är 1,6 terabyte/s och IO-bandbredden 64 Gbyte/s. I höst släpps även kort, Viper, i halva storleken.

Vinsten med en lokal accelerator mot en accelerator i molnet är kortare fördröjningar och att det är enklare att gerantera personlig integrit i konversationerna mellan människa och maskin när dialogen inte är ute och snurrar på nätet.

Andra AI-aceleratorkort som visades på CES i år kom från Panmnesia, DeepX och MemryX. Intel och AMD berättade även om hur de integrerar AI-acceleratorblock direkt i sina processorer.

I väntan på att de dedikerade acceleratorerna ska bli klara är det Nvidias grafikkort som får hantera lokal AI-acceleration. De ligger dock i en högre prisklass. Nvidia visade upp kortet RTX 4080 Super som kostar 999 dollar, levererar 836 Tops och drar upp till 320 watt.

KÄLLA: IEEE Spectrum, Neuchips