Tunga beräkningar inom AI-tekniken deep learning görs idag huvudsakligen i grafikkort. Nu utmanas de av fpga-kärnor och special-sydda asicar.

Tunga beräkningar inom AI-tekniken deep learning görs idag huvudsakligen i grafikkort. Nu utmanas de av fpga-kärnor och special-sydda asicar.

I maj avslöjades att Google använt egenutvecklade asicar med artificiella neuronnät i sina datacenter i ett år.

Det var den första signalen om att den nuvarande dominansen av grafikkort från Nvidia för AI-tekniken deep learning kan vara på väg att brytas.

| HÄR ÄR GRAFIKKORTSUTMANARNA

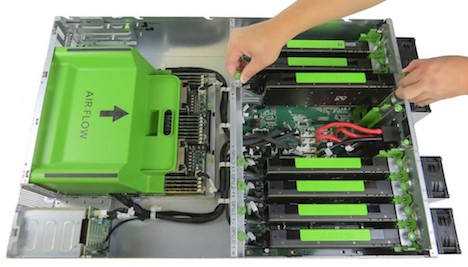

Intel, Google och Microsoft finns bland företagen som just nu investerar tungt i deep learningteknik på alla fronter genom uppköp, samarbeten och utveckling av sin befintliga teknik. Intel har redan stöd för deep learning i sitt superdatorchip Xeon Phi som idag tuggar deep learningalgoritmer i molnet. Stödet ska bli ännu bättre i 2017 års modell Knights Mill (nej, inte ”Knights Hill”) som bland annat stöder lägre precision och därmed ger plats åt större nät. Till sin hjälp har Intel amerikanska Nervana systems som Intel köpte i augusti för ”klart mer än” de 350 miljoner dollar som ett rykte talade om efter köpet. Nervana har redan samarbetat med Intel i två år. Företaget har en egen deep learning-molntjänst som ska upgraderas till företagets eget deep learningchip som släpps i 28 nm TSMC under första kvartalet nästa år. Nervanas molntjänst går idag på Nvidia Titan X-gpu:er och det egna chipet ska göra tjänsten 5–6 gånger snabbare. Tillsammans med Intel ska Nervana därefter gå vidare till ett 14 nm-chip. Nvidia är med sina grafikkort de factostandarden för träning av deep learningnät idag. Företaget satsar stenhårt på att behålla positionen genom att optimera den nya gpu-generationen Pascal för deep learning, och släppa olika acceleratorkort. Ett av dessa acceleratorkort för deep learning, och annat smått och gott – ett gigantiskt kort kallat Nvidia Drive PX system – används i Volvos autopilotexeperiment nästa år. För ett år sedan ägde Google 8 000 stycken grafikkort som användes för träning av neuronnät. Men Google har sedan ett år redan kört servarrack med en egen deep learningprocessor kallad TPU (Tensor Processing Unit). Det var bland annat dessa TPU-rack som besegrade Go-mästaren Lee Sedol. En kopia av segerställningen sitter som ett plakat på ett av racken. TPU stöder bland annat åttabitarsprecision. Amerikanska Knupath agerade i det tysta fram till i juni i år efter att ha haft militära kunder i fem år. Den egna AI-processorn heter Hermosa och ska vara åtta gånger effektivare än grafikprocessorer när det gäller en äldre maskinlärningsalgoritm kallad k-means. Hermosa består av 256 små dsp-kärnor ordnade i ett hierarkiskt nät. Uppstickaren Wave Computing ska andra kvartalet börja leverera nyckelfärdiga deep learningserverrack på en egenutvecklad åttabitarsprocessor i 16 nm FinFET. Den kallas DPU (Dataflow Processing Unit), har 64 000 processorelement och ska enligt Wave vara hundra gånger snabbare än motsvarande gpu. Också fpga:er finns med i konkurrensen. De har visserligen lägre topprestanda men är strömsnålare än gpu:er och kan som bekant skräddarsys, vilket kinesiska Deephi tagit fast på. Företagets fpga-verkyg kan både leka med antalet bitar som används i noder i nätet, och kan skära bort delträd som inte påverkar precisionen – sådan gallring kan krympa bort 90 procent av ett deep learning-nät. Xilinx köpte i början av året uppstarten Teradeep och dess fpga-acceleratorkort och kärnor för deep learning som sägs ge tio gånger mer per watt än gpu:er. Microsoft gör deep learning i fpga-kort i sina halar för molntjänsten Azure. En stor fördel för ett molntjänstföretag är att samma fpga – Altera Stratix V och snart kanske Stratix 10 – på en sekund kan växla till en helt annan funktion, som komprimering eller kryptering. |

Sedan dess har fler asic-projekt inom deep learning avslöjats. Uppstickaren Wave är den som lovar allra mest: en hundrafaldig uppsnabbning vid ett byte från grafikkärnor till företagets asic.

AI-tekniken deep learning krossade konkurrerande maskininlärningsmetoder när den slog igenom. Därefter har tekniken gång på gång krossat sina egna gamla rekord.

Rekorden slås i takt med att forskarna tar kraftfullare hårdvara i bruk och därmed kan använda större neuronnät, större träningsvolymer och fler iterationer.

När steget togs från cpu:er till gpu:er ökade prestanda hundrafalt. Men avancerade tillämpningar kräver fortfarande dagar av beräkningar i stora severrack.

Som exempel kan du idag köpa en van Gogh-animerad version av din semestervideo i 720p-upplösning – jo, deep learning används till många udda saker – men filmen kostar 2 500 kronor per minut, och det ska vara kostnadsmotiverat.

Antalet företag som utnyttjar deep learning kan snart komma att explodera, vilket ytterligare motiverar investeringar i dyra asicar.

Deep learning är en samling metoder att programmera så kallade artificiella neuronnät, datorer utformade med bilogiska hjärnor som förebild.

De nya deep learningnäten är betydligt större de brukade vara förr. Framför allt djupare, därav namnet. Dessutom är de mer självständiga – de matas med rådata, medan äldre neuronnät krävde data som transformerats och masserats av mänskliga experter.

Artificiella hjärnceller skickar en utsignal till sina grannar nedströms om kombinationen av deras insignaler matchar ett mönster de individuellt fintrimmats att känna igen. Det låter avancerat, men matematiken är inte direkt någon hjärnkirurgi, utan består huvudsakligen av matrismultiplikationer, alltså samma sorts operationer som används i allt från klimatsimuleringar till 3D-grafik.

Det är därför gpu:er slagit igenom som plattform deep learning, liksom de redan idag används för generella beräkningar. Gpu:er är dock inte optimala. En av neuronnätens egenheter är att de inte behöver hög precision, åtta bitar räcker gott och väl. En annan att matriserna är mycket stora, med hundratusentals värden.

Och så har näten preferenser för vissa ovanliga matrisoperationer. Sammantaget finns gott om utrymme för att en skräddarsydd asic kan överträffa en gpu.

Chipets genomströmning kan vara en avgörande faktor i och med att gigantiska datavolymer strömmar igenom dem under programmeringen. Det är en av orsaken till att också fpga:er blivit intressanta för deep learning. Fpga:er har dessutom en fördel i sin flexibilitet som gör att de kan anpassa sig exakt till ett givet neuoronnäts topologi – som det finns stor variation i, även dynamiskt.

Och så har fpga:er inga problem att växla ner till åttabitarsaritmetik, eller ännu mindre – ända ner till en enda bit förekommer i neuronnäten.

Deep learning har höjt kvaliteten dramatiskt på översättning, bildtolkning, röststyrning, talgenerering, och andra gamla AI-utmaningar som till slut efter decennier av pinsamma försök har börjat fungera riktigt bra.

Google, Facebook, Microsoft och IBM är några av de företag som satsar stort på utveckling av deep learningteknik. Andra IT-jättar som Apple, Yahoo och Baidu är flitiga användare.

Alla tillverkare av självkörande fordon är användare genom att de behöver kunna tolka miljön kring fordonet och det finns ingen teknik som ligger i närheten av deep learning när det gäller att kunna läsa ut information ur bilder.

|

| En semestervideo som van Gogh kanske skulle målat den. Deep learning-nät kan förfalska både handstil och röst, och kan skapa torgkonstversioner av dina fotografier i kända konstnärers anda. Klicka för större bild! |

Den här texten tar huvudsakligen upp hårdvara som finns på dagordningen för att lanseras kommersiellt för att köra deep learning-algoritmer.

Det finns också en fåra av forskningsinriktade ”neuromorfa” chips, med fokus på att efterhärma hjärnan i detalj, genom att exempelvis använda analoga spikpulser istället för digitala beräkningar. Här finns bland annat projektet Spinnaker, memristorbaserade chips och IBM:s neuronnäts-asic Truenorth. De är normalt inte kompatibla med standardverktygen för deep learning.

AMD:s grafikprocessorer används för deep learning, men företaget visar inget intresse av att stödja tekniken och har helt distanserats av Nvidia.

| Denna artikel publicerades i septembernumret av magasinet Elektroniktidninget. Magasinet är gratis för dig i den svenska elektronikbranschen. Du ansöker om prenumeration här (länk). |

Denna text handlar dessutom huvudsakligen om kraftfulla chips för användning i datacentraler för att träna neuronnät. Neuronnät sprider sig även till svalare processorer. Googles språköversättning bygger på deep learning men fungerar okej off-line i en Android-app som använder 30 Mbyte data. Qualcomms plattform Zeroth kan köra tränade neuronnät i Adreno-grafikkärnan på mobilprocessorn Snapdragon 820. Intel köper irländska Movidius och dess chips för bildanalys bland annat för att förbättra sin djupkamerateknik Realsense.

I en ännu lägre effektklass hittar vi Intels wearables-processor Quark SE C1000. Den innehåller ett neuronnät som visserligen använder äldre ”platta” maskininlärningsalgoritmer kallade k-NN och RBF, men demonstrerar att det kan finnas energiskäl till att lägga in deep learning-nät även i knappcellsdriven elektronik.

LÄSTIPS: nextplatform.com har en utmärkt bevakning på hårdvara för deep learning