15–30 gånger snabbare än både GPU, CPU och FPGA. Googles tester visade att det fanns mycket att vinna – 15 nya datacenter närmare bestämt – på att ta fram en asic för den heta AI-tekniken deep learning.

15–30 gånger snabbare än både GPU, CPU och FPGA. Googles tester visade att det fanns mycket att vinna – 15 nya datacenter närmare bestämt – på att ta fram en asic för den heta AI-tekniken deep learning.

Google har publicerat en första vetenskaplig rapport kring sitt egenutvecklade AI-chip TPU (Tensor Processing Unit).

TPU-processorerna sitter samlade i kort i rack i Googles serverhallar. Ett av deras största jobben är att lyssna på vad du säger när du röstdikterar för din Androidtelefon – det handlar om miljarder gånger per dag som TPU:erna ägnar sig att tolka ett stycke ljudinspelning till text.

Tolkningen sker med hjälp av så kallade djupa neuronnät, som är vad en TPU är specialbyggd för att implementera.

|

|

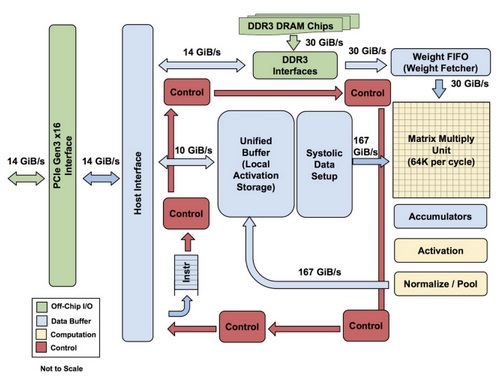

Du som arbetat med neurala nät känner igen dig i systemskissen: via PCI Express från vänster kommer sensordata, medan vikter till neuronnätet hämtas in från DRAM-minnet uppifrån. Allt rullas in och möts i en matrismultiplikation i en diagonal våg. Därefter slussas utdata genom den så viktiga så kallade övergångsfunktion som avrundar utdata från matrismultiplikationen så att hela systemet blir ickelinjärt och därmed intressant. Avrundningen kan sägas innebära att den artifciella neuronen sätter ner foten och bestämmer sig för en tolkning – ett eller noll – av sina indata. Och så snurrar utdata ett varv till som indata till nästa skikt i det djupa neuronnätet, och nästa, och nästa, tills indata passerat genom alla skikt i det djupa nätet |

TPU:erna gör enbart så kallad inferens – de används för att läsa ut kunskap ur färdigtränade neuronnät. För programmering – ofta kallat träning – av de djupa neuronnäten använder Google AI-trimmade grafikkort från Nvidia.

Kring 2011 började började Google inse att användandet av företagets AI-tjänster som bildanalys, översättning och rösttolkning, skulle komma att ta enorma beräkningsresurser i anspråk. Företaget började utvärdera alternativen.

Det visade sig finnas stora vinster att göra i att utveckla en egen asic. Grafikprocessorer och cpu:er gick ungefär på ett ut i prestanda Googles specifika tillämpningar – kanske överraskande med tanke på att grafikprocesser är ganska välutrustade för den matrisalgebra som neuronnät behöver.

Även FPGA:er låg på samma nivå, bland annat på grund av ett stort overhead.

Därmed satte Google igång med att bygga en asic. 70 personer – en försvarbar andel av dem medförfattare till rapporten – utvecklar chipet hos Google under ledning av chipsveteranen Norm Jouppi som har en bakgrund hos HP och DEC. Norm Jouppi anslöt sig till Google sent 2013

I prestanda är TPU:n 15–30 gånger snabbare än GPU:er och CPU:er, och i effektivitet, som mäts i Tops/watt, är skillnaden 30–80 gånger.

Det här är långtifrån den första asic att implementera neuronnät – Google gör en genomgång av detta i sin rapport – och den innehåller inga dramatiska arkitetumässiga genidrag.

TPU:n har redan varit i tjänst i två år. På en av serverrackens sida sitter den vinnande ställningen från det parti då den besegrade den mänsklige världsmästaren i go för ett år sedan.

Elektroniktidningen kommenterar: Om Google inte bygger eller redan byggt en TPU också till sin plattform för självkörande bilar, som är beroende av djupa neuronät för bildtolkning, kommer Elektroniktidningen äta upp sin hatt, med presskort i brättet.

Effektförbrukning är en av de viktigare parametrar som beräkningshårdvaran för självkörande bilar tävlar med. Budgeten för Nvidias senaste kort som används i mer än 80 självkörande bilar ligger på 250 watt medan den färska konkurrenten Mentor lovar 100 watt. Om Google kan göra lika mycket sensordatakrossning på till exempel tio watt, eller dubbelt så mycket och dessutom med tre gångers redundans, på samma effekt, så betyder det någonting.