AI-processordominanten Nvidia licenserar teknik från en konkurrerande uppstickare, Groq. Och tar över personal. Avtalet ska inte vara exklusivt. Ändå är det tre gånger mer värt än Groq självt värderats till.

AI-processordominanten Nvidia licenserar teknik från en konkurrerande uppstickare, Groq. Och tar över personal. Avtalet ska inte vara exklusivt. Ändå är det tre gånger mer värt än Groq självt värderats till.

Groq är en av flera utmanare inom AI-processorer – kretsar för träning och körning av artificiella neuronnät. Du hittar Groq i Elektroniktidningens arkiv sedan 2017.

Företaget har haft kunder inom AI-marknaden och driver även ett eget moln, Groqcloud.

AI-hårdvarumarknaden domineras idag av Nvidias grafikkort. Men det finns tydligen någonting i uppstickaren Groqs teknik som Nvidia känner att det behöver licensera. Tekniken ska dessutom integreras i en Nvidiaprocessor.

År 2020 var Groq klart snabbare än Nvidia på att köra artificiella neuronnät, i ett oberoende test. Enligt Jonathan Ross – som härmed lämnar sitt jobb som vd för Groq för att istället leda implementeringen av Groqs lösningar på Nvidia – är Groq fortfarande snabbare.

På grund av att arbetskraft ingår i affären, inte bara en licens, kallas affären i media för en ”acqui-hire” i meningen att det som Nvidia är ute efter är att lägga beslag på kompetensen hos personalen.

Nvidia lägger upp 20 miljarder dollar kontant för att få igenom affären, enligt CNBC. Det är paradoxalt nog nära tre gånger mer än Groq värderades till i september – 6,9 miljarder dollar. Detta trots att Groq fortsätter att ha rätt att licensiera samma teknik även till andra aktörer.

Groq fick krigskassan påfylld av bland annat Cisco. Och av Samsung, som äter sin egen hundmat – Samsung tillverkar Groqs kretsar i 4 nm i sin process SF4X.

Det finns även ett bredare mönster som hjälper förklara det gigantiska beloppet: AI-industrin regnar just nu dollar kring sig som Lil Wayne på strippklubb. Det finns en spridd tro på en extrem tillväxt inom AI-marknaden.

Analytiker spekulerar att Nvidia egentligen vill köpa Groq, men inte törs på grund av konkurrensregler och sitt de facto-monopol.

En fråga för amerikanska konkurrensmyndigheter att utreda blir om Nvidias licensensering och personalöverföring istället för köp, är en skenmanöver för att rensa marknaden från en potentiell utmanare.

Groq grundades av personer från det team som utvecklade Googles AI-processorfamilj TPU. Google var först på marknaden att investera i en dedikerad neuronnätsprocessor för molnet.

Google bestämde sig för att gå all-in på AI redan under den förra AI-vågen på 10-talet. Google räknade ut att det behövde ta fram dedikerade kretsar för att inte behöva en massa nya strömslukande datahallar.

Google fortsätter att använda TPU för sina egna beräkningar. Sedan 2019 kan även du köra den, i Googles AI-moln.

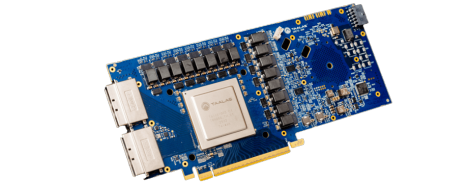

Vill du ha en egen fysisk neuronnätsaccelerator i hårdvara i samma klass som TPU, så har Groq varit det närmaste du kunnat komma ett alternativ.

Groq grundades redan året efter att Google lanserade sin första generations TPU. Idag är Google uppe i sin sjunde generation.

Groq kallar sin AI-processor för en ”LPU”, language processing unit. Men det började Groq att göra 2023, strax efter Chat GPT:s breda genomslag. Så det har inte med processorn i sig att göra, utan är för att rida på vågen för lingvistisk AI. Fram till dess kallade Groq den för en TSP, Tensor Streaming Processor, mer likt Googles namn.

Genetiskt härstammar Nvidias AI-processorer från grafikprocessorer. Medan Groqs processor liksom Googles TPU är en systolisk array. Det är en arkitektur med anor ända tillbaka till 1944, och bromsas därför i grunden inte av patent idag.

Men som Google kan vittna om finns det alltid någon därute med ett patent. TPU använder numeriska datatyper med låg precision, eftersom det duger bra för körning av artificiella neuronnät. En MIT-professor stämde Google på 5 miljarder dollar för patent kring lågprecisionsaritmetik. Det slutade med en hemlig ekonomisk uppgörelse.

Om Nvidia planerar att skapa en egen systolisk array för AI får Nvidia en springande start med Groqs ritningar och ingenjörer. Där finns tio år av kompetens, tekniska lösningar – och intellektuella rättigheter som kanske skulle kunna ha använts för att stämma Nvidia.