Facebook är en av de presumtiva kunder som styr utvecklingen av processorn Nervana NNP – Intels försök att möta Nvidias dominans inom hårdvara för träning av neuronnät. Det avslöjade Intel i veckan under en gala arrangerad av Wall Street Journal.

Facebook är en av de presumtiva kunder som styr utvecklingen av processorn Nervana NNP – Intels försök att möta Nvidias dominans inom hårdvara för träning av neuronnät. Det avslöjade Intel i veckan under en gala arrangerad av Wall Street Journal.

Amerikanska Intel bygger sin portfölj inom den nya vågen av artificiell intelligens genom att köpa ledande AI-hårdvaruföretag och klistrade sin egen logga över deras.

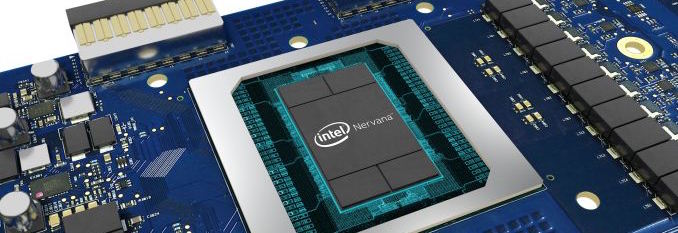

Ett av företagen, Nervana, släpper nu sitt första chip i provexemplar och tror sig kunna börja leverera hårdvara till nyckelkunder innan årets slut.

Chipet har utvecklats i tre år (Intel köpte Nervana för ett år sedan) och har tidigare kallats Lake Crest, men kallas nu helt enkelt för Intel Nervana NNP (neuronnätsprocessor).

Nervana konstruerar hårdvara – kärnor, chip, kort, rack, rubbet – för användning i molnserverfarmer för träning av artificiella neuronnät.

En av kunderna kan bli Facebook, eftersom det företaget enligt Intel har fått vara med och styra utformningen av produkterna.

Det avslöjade Intel under en gala arrangerad av Wall Street Journal i veckan. I övrigt repeterade Intel i huvudsak redan kända uppgifter om Nervanas teknik.

Den teoretiska fördelen för Nervana mot Nvidia är att Nervanas kärnor är konstruerade från ett blankt papper för att vara optimerade för neruronnätsträning, medan Nvidias kärnor härstammar genetiskt ur företagets grafikkärnor. Träning av neuronnät är extremt enahanda.

CPU:ers flexiblitet behövs inte och det finns alla chanser att optimera ett chip för uppgiften. Uppgiften är dessutom som det heter ”pinsamt parallelliserbar”, så det finns stora chanser till uppsnabbning med enkla medel.

Intel säger sig vara först på marknaden med ett kommersiellt chip skapat från grunden för neuronnätsträning.

32 GByte HBM2-minne är stackat på Nervanas chip och kan accessas i 8 terabit/s. Det finns inga traditionella cachemekanismer.

Som typiskt i prestandaberäkningar är datatransport en flaskhals. Intel har tagit fram egna snabba protokoll och det ska gå att parallellkoppla chip 20 gånger snabbare än PCI Express med linjär uppsnabbning av träningen som följd.

Som typiskt i neuronnätsprocessor innehåller Nervana NNP flera block som utför matrismuliplikationer. Nervana använder här ett eget numeriskt format kallat Flexpoint, som tillåter att multiplikationer sker med fast decimalkomma – vilket är snabbt och använder färre transistorer – trots att operanderna och produkten egentligen är flyttal.

Redan år 2020 lovar Intel att ha tagit fram kretsar som är 100 gånger effektivare än första generationen av Nervana NNP.

Det krävs extremt mycket beräkningskraft för att konstruera ett neuronnät för en specifik mönsterigenkänningsuppgift, som att känna igen katter på bild. Nvidia är den överlägset ledande leverantören av hårdvara för jobbet.

Intel har tidigare försökt hålla fram den egna multiprocessorn Xeon Phi som en konkurrent, men köpet av Nervana gav Intel en arkitektur som kan konkurrera på allvar, och det är den som Intel satsar på nu. Nervanas tidigare vd chefar över Intels hela AI-division.

En kommande generation av Xeon heter Knights Crest och kommer att ha en integrerad Nervanakärna.